- 서버전문업체 아이티마야

- HPC서버

-

GPU서버

-

4GPU Server

-

8GPU Server

-

HGX Server

-

2GPU Workstation

-

4GPU Workstation

-

나라장터 등록제품

-

Compact AI

-

10GPU Server

-

- BigData서버

- 가상화/HCI

- 스토리지/파일서버

-

WEB/WAS/DB

-

WEB Server

-

WAS Server

-

고성능 DB

-

타워형서버

-

나라장터 등록제품

-

-

워크스테이션

-

1CPU Workstation

-

2CPU Workstation

-

나라장터 등록제품

-

-

MLOps/SW지원/유지보수

-

Cloud

-

Open Source

-

NVIDIA

-

HCI

-

Backup

-

MLOps

-

HW/SW 유지보수

-

AS

-

테크니컬 스토리

아이티마야의 새로운 기술 뉴스를 만나보세요.우리가 쉽게 접하는 일반 서버는 CPU, Memory, Storage의 운영에 맞춰 설계된 반면, GPU 전용 서버는 GPU의 안정적인 운영을 위해 설계되었습니다.

큰 차이점은 3가지 입니다.

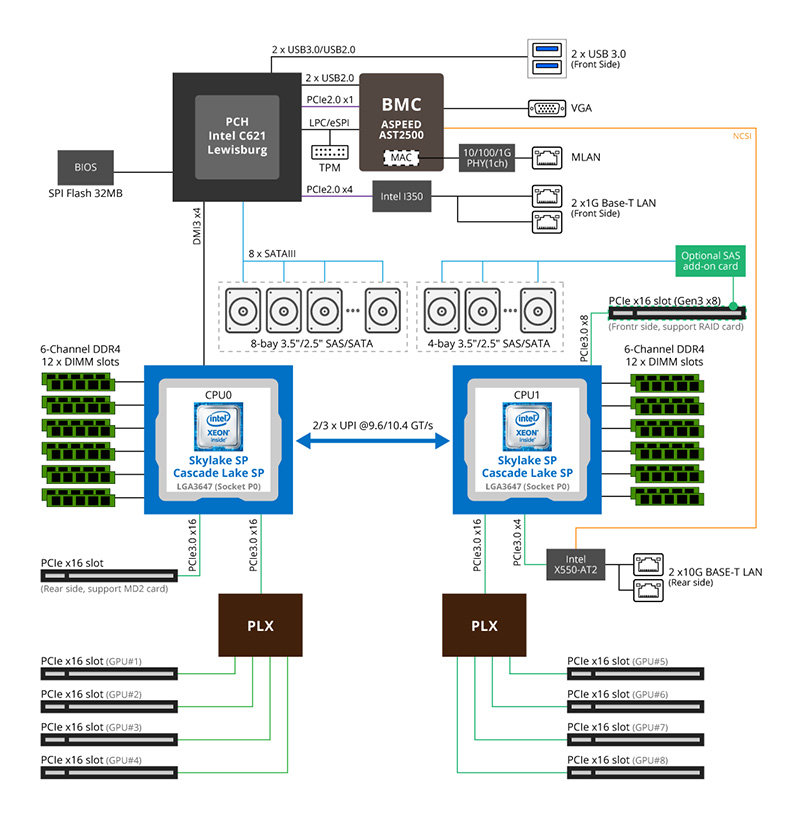

프로세서마다 차이가 있지만 인텔 프로세서를 기준으로, 평균 CPU 1개당 40개의 PCI 레인을 확장할 수 있습니다. 이는 우리가 흔히 말하는 “PCIe 16배속 그래픽카드” 의 “16배속" 이 “16개의 레인” 을 뜻합니다. 서버는 GPU외에도 USB, LAN, IPMI, RGB, BMC, BIOS 등의 다양한 장치가 필수로 운영되어야 하고 이는 적게는 1개, 많게는 4개까지의 PCIe 레인을 사용합니다. 기본 10개정도의 PCIe 레인을 사용한다고 가정하면, CPU 1개당 최대 2개의 16배속 GPU를 장착할 수 있습니다.

![]() 채굴장비에는 CPU 1개에 8개이상의 GPU를 장착합니다. 어떻게 그럴수 있을까요?

채굴장비에는 CPU 1개에 8개이상의 GPU를 장착합니다. 어떻게 그럴수 있을까요?

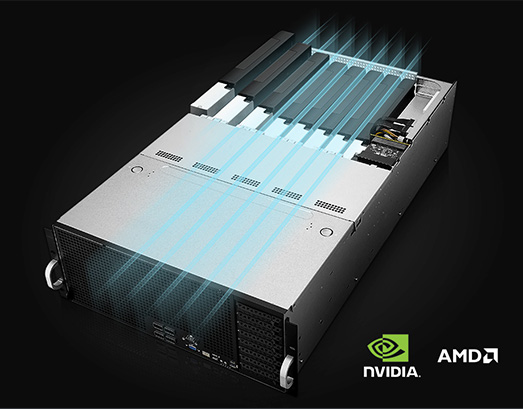

답은 간단합니다. GPU마다 1배속만 할당하면 됩니다. 전송대역폭을 낮추어 동작하게 하여도 채굴에는 큰 영향을 끼치지 않습니다. 하지만 이 대역폭은 머신러닝에서는 매우 중요합니다. GPU전용 장비에서는 다수의 GPU 병렬 사용을 위해 PLX를 채택하여 PCIe 레인을 확장하고 1개의 CPU만으로 128개 이상의 레인 사용이 가능하도록 설계됩니다. PLX는 PCIe 레인 확장을 위해 사용하고 이를 위해 많은 자원이 사용됩니다. 또, 안정적인 GPU운영을 위한 발열설계 및 발열 제어에 필요한 센서, 통제가 함께 장착되어 있습니다.

![]() 그리고 전원부는 눈에 띄는 차이점이 있습니다.

그리고 전원부는 눈에 띄는 차이점이 있습니다.

일반서버는 보통 500W-1000W 를 평균으로 전력이 공급되는 반면, GPU서버는 4000W-5000W의 전력공급장치가 장착되고, 충분히 버틸수 있는 내부 전력설계가 되어야 합니다.

GPU 1개당 최대 피크에 400W 이상의 전력을 소모하고 8개의 GPU를 사용한다면 3500W 이상의 전력이 필요합니다. 일반서버에는 낮은 사양의 GPU 1개 혹은 2개가 장착될 수 있다면, GPU서버에는 고성능의 GPU 8-10개를 장착하여 사용할 수 있습니다.

당연히 추후 장애 포인트도 GPU서버가 훨씬 적습니다. 그리고 GPU서버의 모든 전원은 이중화되어 제공됩니다.

위 내용대로 CPU 1개당 평균 40개의 레인을 사용할 수 있습니다.

레인은 대역폭을 PCI-E 3.0 1개 레인의 이론상 최대 전송 속도는 1GB/s 입니다.

채굴은 하나의 낮은 데이터, 복잡한 계산을 GPU로 보내 계산하고 계산된 낮은 데이터를 돌려받습니다. 대역폭이 클 필요가 없습니다. 하여 PCI-E레인을 1레인찍 잘게 쪼개어 GPU에 할당하고 GPU는 낮은 대역폭으로 통신하지만 높은 성능을 낼 수 있습니다.

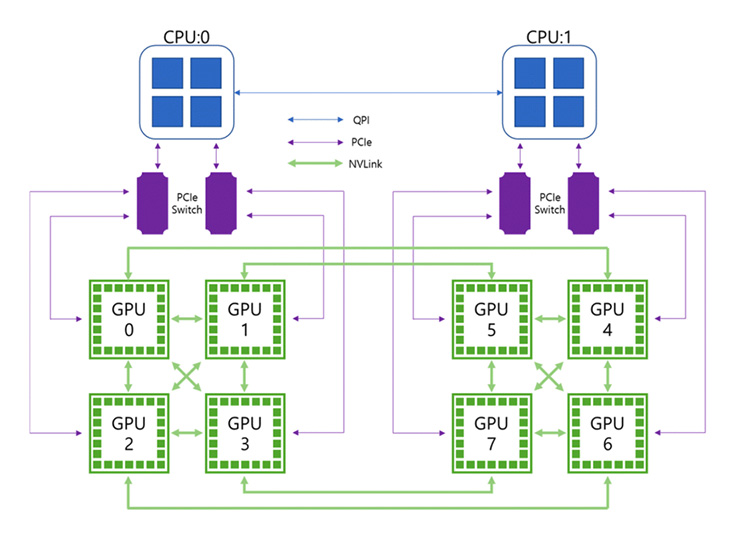

머신러닝은 큰 데이터를 GPU에 보내어 학습 및 연산하고, 학습된 큰데이터가 결과물로 회신됩니다. 대역폭이 머신러닝 성능에 큰 영향을 미칩니다.

고가의 하이엔드급 GPU를 사용할 경우, GPU간 NVSwitch 를 제공하여 모든 GPU간 NVLink가 활성화 됩니다. GPU간 대역폭이 넓어져, 특정작업에서는 NVSwitch 미사용시보다 10배 이상의 성능차이가 나오기도 합니다.

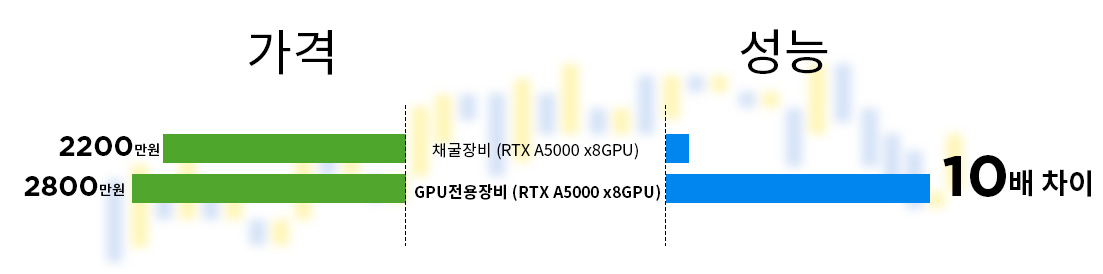

고가의 하이엔드급 시스템이 아닌 일반 GPU전용시스템과 채굴장비도 같은 작업수행시 10배 이상의 성능차를 경험 할 수 있습니다.

![]() 채굴장비와 머신러닝 시스템에서 공통으로 사용하는건 GPU입니다. GPU를 제외한 모든 시스템이 다르죠.

채굴장비와 머신러닝 시스템에서 공통으로 사용하는건 GPU입니다. GPU를 제외한 모든 시스템이 다르죠.

GPU종류마다 다르지만 최근 머신러닝에 많이 사용하는 Quadro RTX A5000 을 예로 든다면 개당 270만원 정도의 금액으로 8GPU 시스템 한대에 GPU가격으로만 2000만원 정도입니다. 플랫폼을 선택한다면 채굴용으로 제작된 조립컴퓨터는 대략 200만원이고, 머신러닝 전용 시스템은 대략 800만원입니다

시스템은 용도에 맞게 사용해야 합니다

G머신러닝장비 구입시 가장 먼저 생각해야 하는건 당연히 GPU의 종류입니다.

하지만 그에 못지 않게 GPU가 동작하는 플랫폼도 중요합니다. 사용 GPU의 최적성능 및 긴 수명을 원하신다면 GPU전용 장비를 사용해야 합니다. 저렴한 플랫폼을 선택한다면 10배 이상의 성능을 손해 볼 수 있고, 짧은 장비 수명으로 큰 비용이 매몰될 수 있습니다.

이전글

이전글