- 서버전문업체 아이티마야

- HPC서버

-

GPU서버

-

4GPU Server

-

8GPU Server

-

HGX Server

-

2GPU Workstation

-

4GPU Workstation

-

나라장터 등록제품

-

Compact AI

-

10GPU Server

-

- BigData서버

- 가상화/HCI

- 스토리지/파일서버

-

WEB/WAS/DB

-

WEB Server

-

WAS Server

-

고성능 DB

-

타워형서버

-

나라장터 등록제품

-

-

워크스테이션

-

1CPU Workstation

-

2CPU Workstation

-

나라장터 등록제품

-

-

MLOps/SW지원/유지보수

-

Cloud

-

Open Source

-

NVIDIA

-

HCI

-

Backup

-

MLOps

-

HW/SW 유지보수

-

AS

-

테크니컬 스토리

아이티마야의 새로운 기술 뉴스를 만나보세요.이전에는 CPU만으로 연산을 할 수 있었지만, 지금은 CPU만으로는 버겁기 때문에 GPU는 선택이 아닌 필수가 되었습니다. GPU 서버 또는 워크스테이션을 사용하는 사용자들은 내가 사용하는 GPU가 좀 더 유연하고 많은 퍼포먼스를 보여줬으면 좋겠다고 생각을 할 것입니다. GPU를 상위 GPU로 바꾸고 싶어도 비용이 문제가 되기 때문에 이런 고민을 덜어줄 건 NVLink라고 생각합니다.

- NVLink 가 뭔가요?

NVLink는 다중 GPU 시스템에 사용되는 기존의 PCI-E 기반 솔루션보다 더욱 유연한 퍼포먼스를 제공하는 고속 GPU 상호 연결 장치입니다. NVLink를 사용할 경우 GPU사이에 통신 대역폭을 높여 양방향으로 통신할 수 있기 때문에 NVLink 없이 단일 GPU를 사용했을 때 보다 더 나은 성능을 기대할 수 있습니다. ex) A6000 GPU 2개에 NVLink를 연결해주면 ‘최대’ 112GB/s의 대역폭 및 결합된 96GB 메모리를 제공하여 가장 메모리 집약적인 워크로드를 처리할 수 있습니다.

<출처 : NVIDIA A6000 설명 페이지>

- NVLink는 모든 GPU에 호환이 되나요?

NVLink라고 모든 GPU에 호환이 되는 건 아닙니다. 좌측 사진 2장처럼 (NVLink 2세대) 제품들은 쿼드로 제품(RTX5000 등)에 장착이 가능하고 3세대 NVLink(우측 사진 2장)는 A 시리즈 (A100, A5000, A6000 . . . )에 장착이 가능합니다.

- NVLink는 하나밖에 장착을 못하나요?

다른 GPU들은 GPU에 1개의 NVLink 슬롯이 있는 반면 A100 GPU의 경우 3개의 NVLink를 장착할 수 있습니다. 그러므로 총 12개의 NVLink를 장착할 수 있는데 12개 모두 장착한다면 총 600GB/s 대역대를 구현할 수 있는 장점이 있습니다. *앞으로 출시될 H100 GPU도 A100과 같은 1 GPU 3 NVLink 방향으로 출시될 방향으로 예상합니다.

- 최근 딥러닝 환경에서 많이 이용하는 GPU별 대역폭 자료

아래 자료는 Idel 상태의 GPU에 NVLink를 장착했을 때 보이는 대역폭 참고자료입니다.

- [GPU 외 다른 하드웨어 스펙]

- System : ESC8000A-E11

- CPU : AMD EPYC 3rd 7413 x 2

- Memory : 64GB x 8

- M.2 NVMe : SK Hynix Platinum P41 M.2 NVMe 2TB x 1

-

( RTX 3090 GPU x 2 + 3세대 NVLink 1 ) x

-

( A5000 GPU x 2 + 3세대 NVLink 1) x

-

( A6000 GPU x 4 + 3세대 NVLink 1 )

[0번 1번 GPU에 NVLink 장착, 2번 3번 GPU는 장착안함]

위와 같은 참고 사례를 보아도 GPU를 단순하게 사용하는 것보다 NVLink를 사용해서 더욱 유연한 퍼포먼스를 기대하는 게 더 나은 방향이라고 생각합니다.

-

이전글

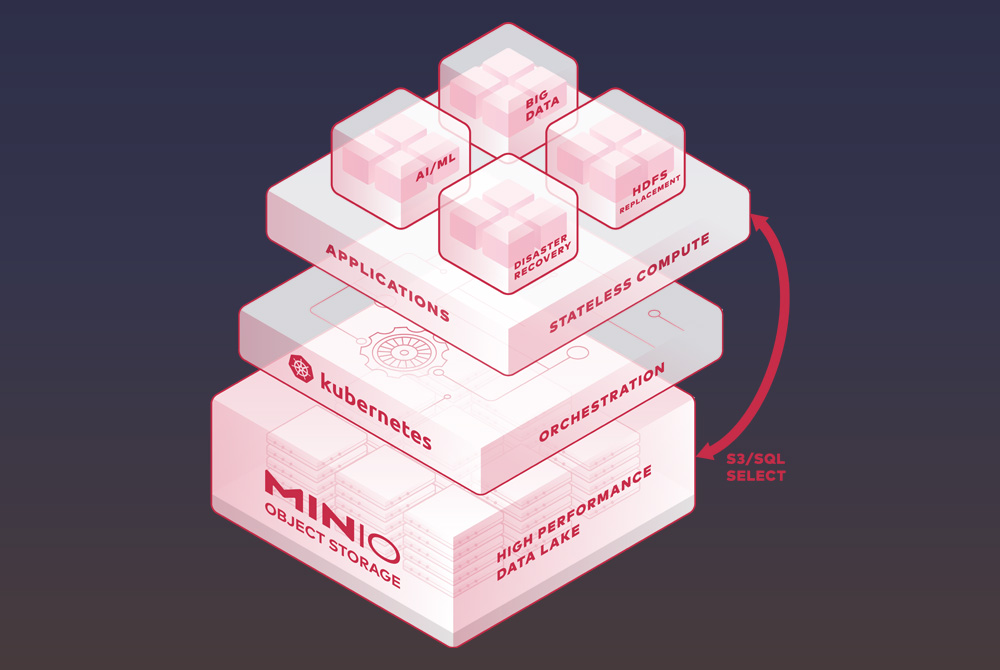

이전글 오픈소스로 제공되는 분산 객체 스토리지 (S3 API 호환)놀랍도록 빠르고, 당장 구현 가능한 분산 스토리지 MinIO 오픈소스로 제공되는 분산 객체 스토리지 (S3 API 호환) MinIO란? MinIO는 오픈소스로 제공되는 분산 스토리지 솔루션입니다. 오브젝트 스토리지로 제공되며, S3 스토리지와 완벽하게 호환됩니다. S3의 SDK를 사용할 수 있습니다. MinIO은 파일 스토리지, 블록 스토리지 형태로 제공되...2022.10.25

오픈소스로 제공되는 분산 객체 스토리지 (S3 API 호환)놀랍도록 빠르고, 당장 구현 가능한 분산 스토리지 MinIO 오픈소스로 제공되는 분산 객체 스토리지 (S3 API 호환) MinIO란? MinIO는 오픈소스로 제공되는 분산 스토리지 솔루션입니다. 오브젝트 스토리지로 제공되며, S3 스토리지와 완벽하게 호환됩니다. S3의 SDK를 사용할 수 있습니다. MinIO은 파일 스토리지, 블록 스토리지 형태로 제공되...2022.10.25 -

다음글

왜 머신러닝/딥러닝 개발환경에서 VM환경보다 Docker환경을 선호할까?컨테이너와 차이점 왜 머신러닝/딥러닝 개발환경에서 VM환경보다 Docker환경을 선호할까? 컨테이너와 VM 차이점 가상화를 사용하는 이유는? 현업에서 cpu 사용률이 20%도 안 되는 활용도가 낮은 서버들은 리소스 낭비일 수 있습니다. 그렇다고 모든 서비스를 한 서버 안에 올린다면 안정성에 문제도 생길 수가 있습니다. 그래서 안정성을 높이며 리소스도 최대한...2022.08.19

왜 머신러닝/딥러닝 개발환경에서 VM환경보다 Docker환경을 선호할까?컨테이너와 차이점 왜 머신러닝/딥러닝 개발환경에서 VM환경보다 Docker환경을 선호할까? 컨테이너와 VM 차이점 가상화를 사용하는 이유는? 현업에서 cpu 사용률이 20%도 안 되는 활용도가 낮은 서버들은 리소스 낭비일 수 있습니다. 그렇다고 모든 서비스를 한 서버 안에 올린다면 안정성에 문제도 생길 수가 있습니다. 그래서 안정성을 높이며 리소스도 최대한...2022.08.19